|

||||

|

|

Интервью Дмитрий Вибе (ИА РАН) об астрофизических измерениях Алла Аршинова Опубликовано 29 ноября 2010 года Научное знание копится веками. В стремлении постичь мир ученые строят гипотезы и теории, проектируют и воплощают в жизнь сложнейшие научные установки. В естественных науках все можно проверить экспериментом. Практически весь мир (условно, конечно) можно поместить в научной лаборатории. Именно здесь решаются проблемы медицины, физики, химии, биологии, генетики и других наук. Но есть нечто, что никогда не поместится ни в одну лабораторию мира. Это — наша Вселенная. «Эксперименты» с ней может проводить только сама природа, а человеку остается лишь наблюдать за этим процессом. Астрономия, наука о строении, развитии и структуре небесных тел и Вселенной, стоит особняком среди естественных наук, так как ей недоступны прямые эксперименты, и строить свои теории она может, лишь отталкиваясь от наблюдательной базы. Тем не менее мы знаем, что такое звёзды, как движется межзвёздное вещество, почему и как Вселенная расширяется и другие, немыслимые для обывательского понимания вещи. На чем основано это знание? Насколько оно надёжно и обоснованно? На что опирается астрономический научный аппарат? О методах астрофизических измерений мы разговаривали с доктором физико-математических наук, ведущим научным сотрудником Института астрономии РАН Дмитрием Вибе.  - Дмитрий Зигфридович, насколько обоснованно сегодня разделение астрофизики на наблюдательную и теоретическую? - Это разделение присуще всем естественным наукам, и астрономия (астрофизика) — не исключение. Общий принцип работы незыблем: наблюдатель при помощи телескопов собирает информацию, теоретик при помощи моделей пытается понять, что она означает. При этом современный телескоп — это устройство, очень сложное в технологическом плане, и без должной квалификации невозможно ни составить план наблюдений, ни провести их, ни обработать потом результаты. Астрофизические модели также очень сложны, поскольку моделировать приходится очень сложные реальные объекты. Поэтому даже в простой модели зачастую сочетаются в той или иной степени чуть ли не все отрасли современной физики. Поэтому быть одновременно и хорошим наблюдателем, и хорошим теоретиком одному человеку невозможно. С другой стороны, конечно, наблюдатель должен иметь представление о теоретических моделях (чтобы наблюдать то, что нужно для их подтверждения или опровержения, а не то, что удобно наблюдать), а теоретик должен иметь представление о возможностях современных телескопов (чтобы результатом моделирования была не красивая анимация, а реально проверяемое предсказание). - Астрономия вообще и, в частности, астрофизика, развивается стремительнее многих других наук. С чем это связано? Что является двигателем прогресса в этой науке? - Двигателем прогресса в астрофизике, как ни скучно это прозвучит, является развитие технологий. За последние несколько десятилетий (начиная, скажем, с середины прошлого века) астрофизическая картина мира претерпела кардинальные изменения. При этом собственно физическая основа астрофизических моделей за это время проэволюционировала не столь значительно. До сих пор в профессиональной литературе в ходу имена Кеплера, Ньютона, Эйлера, Максвелла... Но вот техника наблюдений и моделирования изменилась неимоверно. Соответственно, грандиозно вырос объём информации о Вселенной, которую мы в состоянии получить и обработать. Главное достижение состоит, пожалуй, в том, что у нас появилась возможность проводить наблюдения во всём диапазоне электромагнитных волн — от гамма-излучения до радиоволн. Да и компьютерная техника заметно «подросла». Первые численные модели астрофизических процессов в 1960-е годы выполнялись на компьютерах, которые в современном мире по мощности могли бы конкурировать разве что с мобильниками. Если же говорить более конкретно, то большой вклад в развитие астрофизики внесла гонка вооружений. Многие численные гидродинамические модели, физические базы данных попадали в астрофизику из Лос-Аламоса и других подобных учреждений. Не для астрофизических нужд разрабатывались изначально такие прорывные технологии, как адаптивная оптика и детекторы жёсткого излучения. Некоторые важные астрофизические явления и объекты (гамма-всплески, инфракрасные тёмные облака) были обнаружены при помощи военных спутников. - Каждая наука имеет свою методологию. Какие есть особенности у методологии астрофизики? - Можно, пожалуй, выделить две ключевые особенности: невозможность проведения запланированного эксперимента и возможность наблюдения исследуемых объектов только с одной стороны. Физик (как правило) имеет возможность так построить эксперимент, чтобы в нём наиболее выпукло проявлялся какой-то специфический процесс. В астрофизике эксперимент ставит Природа, которая нимало о нуждах исследователя не заботится. Допустим, физик хочет в деталях исследовать колебания маятника. Он сделает его из немагнитного материала, поместит на жёстком подвесе в суперизолированное помещение, откачает воздух, поставит десять камер, чтобы следить за маятником с разных ракурсов. В астрофизике тот же маятник будет сделан из материала с неизвестными магнитными свойствами, помещён в магнитное поле, подвешен на резинке, с одной стороны на него будет налетать поток газа, с другой — космические лучи, и наблюдать всё это можно будет только с одной стороны, как правило сбоку в плоскости колебаний. Ещё один важный фактор — разнообразные эффекты наблюдательной селекции, суть которых сводится к тому, что внимание наблюдателя привлекают, в первую очередь, наиболее яркие и, как следствие, наименее типичные объекты. Из-за этих ограничений в астрофизике к теоретической интерпретации наблюдений приходится подходить особенно жёстко. В частности, обязательно необходимо проверять, насколько предлагаемое объяснение согласуется с данными из других отраслей астрофизики. Это в общем тоже ложится на учёного дополнительным бременем: он не может позволить себе разбираться только в своей узкой области. - В астрономии много разделов, какой из них самый сложный в смысле получения информации? - Да в общем-то ни один из этих разделов особой лёгкостью не отличается. Но самые значительные сложности, наверное, у космологов. Им приходится иметь дело с очень большим объектом, и для выявления каких-то закономерностей необходимо с высоким качеством наблюдать если не всё небо, то по крайней мере значительные его участки, причём с использованием космических обсерваторий. Эта задача всё ещё остаётся очень ресурсоёмкой. - Каким инструментарием обладает астрофизика? Каким образом, наблюдая свет от удаленных звёзд, астрофизики определяют их параметры? - Практически единственный источник информации о космических объектах — это электромагнитное излучение. Конечно, есть ещё космические лучи и нейтрино, но по информативности они со светом конкурировать не смогут ещё очень долго. Поэтому в основе астрофизического инструментария лежит, с одной стороны, необходимость зарегистрировать электромагнитное излучение, с другой стороны, необходимость понять, как оно было сгенерировано. К счастью, электромагнитное излучение буквально напичкано информацией. Эта информация зашифрована в виде спектра — распределения энергии излучения по частотам. Общая форма спектра зависит от температуры объекта: чем объект горячее, тем дальше максимум его излучения сдвинут в область больших частот (очень горячие объекты светят в рентгеновском и гамма-диапазонах, очень холодные — в инфракрасном и миллиметровом диапазонах), сдвиг спектральных линий относительно «лабораторного» положения говорит о скорости движения вещества по лучу зрения, ширина спектральных линий — о температуре и плотности вещества. По интенсивности различных линий одного и того же элемента можно определить его содержание и состояние ионизации. - Предположим, природу звёзд еще можно постичь. А как быть с более абстрактными явлениями, такими, как кривизна пространства? - На самом деле, природа звёзд не более и не менее абстрактна, чем природа гравитации. Астрофизика, физика, вообще наука — это очень практическая часть человеческой деятельности, в которой не так много места для абстракций. Во всех случаях мы имеем дело с одной и той же логической схемой: есть наблюдения и есть модель, которая их объясняет. Свойства звёзд удаётся объяснить, исходя из предположения, что в их недрах происходят термоядерные реакции. Поведение луча света вблизи Солнца или, например, смещение перигелия Меркурия удаётся объяснить, исходя из предположения об искривлении пространства. Оба предположения являются равноправными составными частями общей физической картины Мира. - Как обнаруживают экзопланеты, ведь они невидимы напрямую? - Почему же не видны? В некоторых случаях внесолнечные планеты уже удаётся наблюдать непосредственно. В других случаях (их, правда, пока большинство) на помощь приходят косвенные методы, из которых наиболее продуктивны метод лучевых скоростей и метод затмений. В первом методе используется тот факт, что на самом деле не планета вращается вокруг звезды, а звезда и планета вращаются вокруг общего центра масс. Это небольшое движение звезды приводит к тому, что она движется то к наблюдателю, то от него. В результате из-за эффекта Допплера её спектральные линии смещаются то в синюю, то в красную область спектра. Эти колебания и выдают присутствие невидимого спутника. Если масса спутника не превышает 13 масс Юпитера, его считают планетой. Правда, метод лучевых скоростей позволяет определить не саму массу, а только её нижнюю границу, точнее, он позволяет определить произведение массы планеты на синус угла между плоскостью её орбиты и небосводом. Метод затмений работает тогда, когда плоскость орбиты планеты почти параллельна лучу зрения. В этом случае планета на каждом обороте проходит перед звездой, частично затмевая её свет. Метод затмений более сложен, но и информации даёт больше. В частности, для затмевающих планет удаётся измерять массы, спектры и радиусы. То есть он, в отличие от метода лучевых скоростей, позволяет не просто зафиксировать сам факт наличия планеты, но и определить её физические параметры и даже свойства атмосферы. - А как можно исследовать свойства атмосферы, если нельзя увидеть даже саму планету? - Здесь также работает спектральный анализ. Если речь идёт о затмевающей планете, то во время затмения, то есть в тот момент, когда планета проходит по диску звезды, газовая оболочка планеты поглощает часть звёздного света, и это добавочное поглощение можно зафиксировать в наблюдениях. В тех же (пока редких) случаях, когда удаётся увидеть саму планету, возможно получить и её спектр — непосредственно, а не в виде едва заметного изменения в спектре звезды. - Чёрные дыры представляют собой особый класс объектов, так как сами ничего не излучают. Каким образом они были обнаружены, и как были измерены их массы? - Измерение масс чёрных дыр — как раз тот случай, когда прекрасно работают законы четырёхсотлетней давности, законы Кеплера. Наблюдая движение вещества по кеплеровским орбитам, можно определить массу того тела, вокруг которого обращается вещество. В ряде случаев оказывается, что вещество вращается вокруг «пустого» места, то есть источник тяготения в фокусе орбиты есть, обладает весьма заметной массой и при этом невидим. Очень наглядный пример — объект в центре нашей Галактики. Вокруг него вращается несколько звёзд, орбиты которых измерены с очень высокой точностью. Из параметров этих орбит видно, что звёзды движутся в поле тяготения объекта массой в несколько миллионов солнечных масс. При этом объект невидим (видно лишь слабое рентгеновское излучение падающего на него газа) и обладает очень небольшими размерами. Всё это — характерные признаки чёрной дыры. - А можно ли объяснить эти признаки, не привлекая теорию чёрных дыр? Есть ли другие гипотезы? - Да, время от времени публикуются статьи, посвящённые попыткам объяснить поведение звёзд в центре Галактики другими объектами — нейтринными шарами, бозонными звёздами и прочее. Однако эти объекты более экзотичны, чем чёрные дыры, а в науке принято правило, согласно которому предпочтение отдаётся более простому объяснению. - Большая часть массы Вселенной состоит из тёмной энергии и тёмной материи, природа которых неизвестна. Как астрофизика изучает их? - Тёмная материя локальна, её признаки наблюдаются не только в масштабах Вселенной, но и в отдельных скоплениях галактик, и в самих галактиках. Поскольку тёмная материя является источником гравитационного притяжения, её распределение можно исследовать по наблюдениям явлений, связанных с гравитацией, например по наблюдениям гравитационного линзирования. Здесь в общем ситуация примерно та же, что и с чёрными дырами, — действие поля тяготения фиксируется совершенно уверенно, а его видимый источник отсутствует. Только речь идёт не об очень компактном массивном теле, а напротив, о распределении невидимого вещества в масштабах скопления галактик. Тёмная энергия — вещь глобальная, и её признаки проявляются в космологических наблюдениях, то есть, по сути, в наблюдениях Вселенной как целого. Но методика и здесь остаётся той же: теоретики рассчитывают, как должна выглядеть Вселенная (крупномасштабное распределение вещества, свойства микроволнового фона) при том или ином соотношении обычного вещества, тёмного вещества и тёмной энергии, а наблюдатели проверяют, насколько эти предсказания оправдываются на практике, например в наблюдениях анизотропии микроволнового фонового излучения. - Расскажите, пожалуйста, о связи астрофизики и физики элементарных частиц! Ждут ли астрофизики каких-то определенных результатов от LHC? - На самом деле, астрофизика — это не какая-то отдельная отрасль физики, подобная физике элементарных частиц или, скажем, физике твёрдого тела. Это скорее система применения знаний из различных областей физики к космическим объектам. Поэтому астрофизика связана и с физикой элементарных частиц, и с кинематикой, и с гидродинамикой. При этом есть, конечно, разделы астрофизики, которые к физике элементарных частиц особенно близки. Это, например, физика космических лучей и космология, исследования вспышек сверхновых и процессы в нейтронных звёздах. Результаты LHC имеют скорее общефизическое значение, чем конкретно астрофизическое. Поэтому рискну сказать, что астрофизикам в массе не так важно, какие конкретно результаты будут получены на LHC. Хотя, конечно, очень интересно будет узнать, какие результаты там будут получены. -А как же, например, эксперименты на LHC, предназначенные для проверки теоретических моделей столкновения космических лучей высокой энергии с молекулами атмосферы? Или вообще проверка Общей теории относительности? Разве новые данные LHC не ограничат (или расширят) модели, используемые в астрофизике? - Астрофизика объединяет в себе сотни, может быть, даже тысячи моделей. В очень многих моделях ни релятивистских эффектов, ни энергий, для которых был построен LHC, нет. Соответственно ни результаты LHC, ни результаты проверок ОТО на этих моделях никак не скажутся. На самом деле если бы, скажем, эффекты ОТО играли столь большую роль в рядовых физических и астрофизических процессах, для проверки ОТО не приходилось бы проводить сложных и дорогостоящих экспериментов. Сложность её проверки обусловлена именно тем, что она зримо проявляется лишь в довольно исключительных обстоятельствах, которые во Вселенной редки. - Может ли современная астрономическая картина мира оказаться неверной? - Это сложный вопрос, и ответ на него будет зависеть от того, что конкретно понимается под астрономической картиной мира и какой смысл вкладывается в слово «неверна». Строго говоря, наши «руки» (в виде космических аппаратов) протянулись лишь чуть дальше, чем на 100 астрономических единиц от Солнца. Всё, что мы «знаем» вне этих пределов, является результатом интерпретации наблюдений электромагнитного излучения и космических лучей, то есть результатом того самого центрального процесса — построения моделей и их сопоставления с наблюдениями. При этом, даже если удаётся построить модель, которая хорошо описывает имеющиеся наблюдения и позволяет предсказать результаты новых наблюдений, остаётся вопрос единственности. Не существуют ли другие модели, которые будут не менее успешны? Тем не менее мне кажется, что в своих основах астрономическая картина мира уже навсегда останется неизменной. Слишком многочисленны и разветвлены наблюдательные факты, на которых она строилась и строится. Невозможно, например, предположить, что энерговыделение в звёздах вызывается не термоядерными реакциями, не потянув массу последствий для других аспектов астрономической картины мира, начиная со структуры галактик и заканчивая химическим составом метеоритов. Об этом, кстати, часто забывают авторы самодеятельных научных «теорий»: в астрофизике факты чаще всего нельзя объяснять поштучно. Сергей Анурьев («ЛитРес») об электронном книгоиздании Юрий Ильин Опубликовано 30 ноября 2010 года "ЛитРес" — компания, занимающаяся легальными продажами электронных книг, образованная создателями электронных библиотек FictionBook.lib, Альдебаран, Litportal, Bookz.ru и Фэнзин в 2006 году. Что поменялось с той поры? И как наступающий бум электронных книг скажется на судьбе книгоиздания в России? Об этом «Компьютерра» беседует с генеральным директором «ЛитРеса» Сергеем Анурьевым.  — Расскажите, пожалуйста, какие изменения в компании «ЛитРес» и отрасли в целом произошли с 2007 года и до сегодняшнего дня? - В 2007 году рынка в полноценном понимании этого слова не было. Был не очень результативный, но несомненно полезный опыт «КМ Онлайн», который предлагал лицензионный ассортимент до тысячи наименований.. У проекта были явные проблемы с генерированием продаж, коммуникацией с правообладателями и работой с пиратами. Наступала новая пора, связанная с изменением Гражданского Кодекса, был очевиден большой спрос на электронные книги, но не было хорошего предложения. Прошло всего лишь три года, а изменилось практически все. Если в 2007 году портфель электронных книг наших ключевых поставщиков АСТ и «Эксмо» насчитывал до ста позиций, то сегодня их суммарное количество увеличилось на порядки и составляет более десяти тысяч позиций. Сам проект «ЛитРес» на старте был обсуждаем и неоднозначен в понимании как авторов, так и потребителей. Предлагалось платить за книги, а тут вокруг пираты и все можно скачать бесплатно. Сегодня пользователь понимает, что есть платные и пиратские модели, и он сам выбирает, какие книги будет читать: лицензионные или пиратские. В целом, сегодня приобретение электронных книг за деньги не вызывает вопросов ни у покупателей, ни у авторов. Это стало привычным подходом к распространению книги в современном мире. Нужно понимать, что на момент 2007 г. за рубежом из аналогичных проектов был только www.ebooks.com. Но о нем было известно только в среде продвинутых специалистов. Книги на ebook.com были представлены на английском языке, и это было отнюдь не массовое явление. В отечественном сознании, которое ориентировано на восприятие всего через какие-то зарубежные аналоги, продажа электронных книг на тот момент была странной затеей. Однако с тех пор произошло множество изменений. Осенью 2007 года вышел первый Amazon Kindle; затем вышел Kindle 2 и в 2010 — Kindle 3. Также в 2010 году на рынок электронной книги вышел Apple с приложением iBook для пользователей iPhone, iPad, iPod и пр. С точки зрения потребителя тоже произошло много изменений: если б в 2007 году какой-нибудь пассажир метро достал читалку, это был бы нонсенс. Сейчас, по нашим оценкам, до трети пользуются для чтения в метро либо телефоном, либо ридером, либо другим устройством для чтения. Пользователи шагнули в сторону прогресса. То есть в 2007 году рынка не было вообще, а теперь он есть и активно развивается. Изменения эти произошли за какие-то два-три года. - Вопрос только в том, какой процент лицензионной продукции у них на этих читалках? - Выбор в пользу лицензионного контента зависит напрямую от пользователя. — То есть вы считаете, что это зависит от людей, а не от того, что есть, а чего нет? Вот сейчас вы упоминаете АСТ и «Эксмо» – это крупные книгоиздатели, которые издают сугубо коммерческую литературу, «жестко коммерческую», если угодно. А какие-то не столь коммерческие поставщики у вас есть? - Я не культуролог и не искусствовед, сложно сказать, какая литература коммерческая, а какая нет. Мы ориентируемся на результаты литературных премий, статистику продаж книжных сетей. Мы изучаем эти рейтинги и понимаем, что аудитория читает и что ей необходимо предложить. В целом, аудитория книги очень разная. Кто-то читает Дарью Донцову, кто-то предпочитает Виктора Пелевина, другие выбирают Дину Рубину.... Рубина — это что? Улицкая — это что? Качественная, но в тоже время, достаточно коммерческая литература. Тут сложно сказать, что из такого «некоммерческого» издательствами выпускается или еще не выпускается. Я просто даже не могу представить... Какую книгу вы хотели бы почитать, но не можете найти? Или какой жанр вы хотели бы почитать, но не можете найти? — Скажем, Владимира Набокова — в лицензионном виде... - К сожалению, у нас существует проблема с книгами Владимира Набоковым, как и с любым другим зарубежным автором: необходимо приобретать права на их издание на русском языке в электронном виде. То есть, например, Рэй Брэдбери — он у нас на расстоянии вытянутой руки, рядышком совсем, все готово, чтобы продавать его книги. Но нужно подписывать с ним контракт через зарубежного агента, а пока это сделать дорого и долго. Но мы работаем в этом направлении. — А классика? От Державина до Белинского, если по школьной программе? - Есть, продаем классику. Не все, правда, положительно относятся к этому. - А почему, кстати? - Считается, что классика является общественным достоянием и должна распространяться бесплатно. Хотя при этом те, кто это утверждает, забывают, что необходимо еще обеспечить качество текста и удобство его чтения на любом устройстве. Именно это мы и предлагаем пользователям нашего сервиса, когда они покупают у нас классику. — Теперь другой вопрос. Как выглядит процесс традиционного книгоиздания? Есть исходный текст, редактура, корректура, подготовка иллюстраций, если это вообще предполагается, верстка, типография, расходы на бумагу и т.д. Электронное книгоиздание, в сущности, эту модель меняет, чтобы не сказать истребляет, не так ли? - Все зависит от того, о какой книге идет речь. Например, появился автор, принес свое произведение, а его нужно редактировать. Редактирование и корректура все равно необходимы, какую бы книгу вы ни покупали. Если книга с иллюстрациями, картинки нужно верстать. Если нет, то ее все равно нужно переводить в какой-то цифровой формат. Верстка видоизменяется. Печать книги, как один из процессов, разве что исчез. — Что у нас остается? Верстка, корректура, если речь идет о западных каких-либо произведениях — переводы все равно нужны. Достаточна ли выручка от цифровых продаж, чтобы оплачивать весь оставшийся процесс в том же объеме, в каком это делалось до появления электронных книг? - Бумажная книга вместе с электронной идут вместе, одним процессом. Они — единое целое. Пока книга не напечатана, электронная и бумажная книга выглядят одинаково, – файл в программе верстки, например в InDesign. Только потом уже из файла верстки делается PDF для печати. Пожалуй, только печать является единственным процессом, который работает исключительно на бумажную книгу. — А если печать совсем уходит? Сейчас существует распространенное мнение, что через некоторое время бумажная книга отомрет в принципе, потому что, дескать, все эти букридеры удобнее, и если и не надежнее, то, во всяком случае, в них больше помещается. В один Kindle можно чуть ли ни всю домашнюю библиотеку «упихать». А вот если бумажная книга уходит, то вот этот процесс финансового возвращения, он как осуществляется? - Бумажная книга уйти «в никуда» не может. По идеи на ее место, как минимум, должна прийти электронная книга. Но в обозримой перспективе бумажная книга все равно останется доминирующим способом донесения авторского продукта до широкой аудитории. — Ну да, если она приходит полностью? - Да, тогда электронная книга будет оплачивать это процесс. Суть в том, что все деньги должны попасть в итоге к издателям и авторам. Если тысяча рублей, потраченная на книги, останется в игре, то какая разница, с какой книги их получит издатель, чтобы окупить эти процессы. С бумажной или электронной книгой — ему все равно. — Высказываются такие мнения — кстати, похоже, небезосновательно, — что рынок традиционного книгоиздания ждет примерно та же судьба, которая постигла музыкальную отрасль. Жадные лейблы заламывали бог знает какие цены на CD, а потом пришли интернет и MP3 и продажи дисков упали. Потребитель думает: зачем мне покупать диск, какого-то кота в мешке, пока я не услышу, что там на этом диске? А послушав MP3, он думает: я это уже слышал, зачем мне за CD платить? С книгами такого не произойдет случаем? И не происходит ли уже? - — Сложно сказать, В перспективе, я думаю, что произойдет изменение структуры рынка в пользу электронной книги. Изменится средняя цена на книгу, но при этом вполне возможно вырастет и потребление книг. Так что судьба издательств далеко не определена. Если они начнут активно работать с электронной книгой, то могут получить рост продаж, а не спад, который был на музыкальном рынке. Все-таки книги другой продукт, потенциально более богатый по эмоциям, вовлечению и получению обратной связи от потребителя. — Но если весь процесс сильно падает в цене, соответственно падает в доходах все остальное. - Не падает в цене... Издательская процедура без печати потребляет не такие уж большие деньги для каждого проекта. Процессы эти НЕ ОЧЕНЬ затратные. Я думаю, что по некоторым книгам продажи электронных вариантов уже могли бы окупать эти процессы, просто издатели не направляют их целевым образом. Пока рост доходов от электронных книг рассматривается как приятное дополнение. В разговоре со многими издателями часто можно услышать: «Мы не ожидали, что электронная книга принесет нам столько денег». Это говорит о том, что это для них приятное «дополнение», но и не более того. — Кто как. Мы недавно опубликовали интервью с книгоиздателем, который полагает, что электронная книга вполне может оставить традиционное книгоиздание не у дел полностью. - Он-то, может, и обеспокоен, но если ему за электронную книгу станут платить, он, скорее всего, высказываться против не будет. — У него нет доказательств, что за электронные книги люди и вправду готовы всерьёз платить. - Нужно сотрудничать с «ЛитРес», тогда эти доказательства будут. Есть много вариантов того, как продать свою электронную книгу. В чем суть модели издательской? Есть книга, которая стоит 200 рублей в розницу. Ее издатель продал за 100. Реальные затраты при тираже 5 тысяч экземпляров на верстку и корректуру максимум 50 тысяч рублей. Что-то он вложил в печать, тысяч 50-100. Авторам он отдал 50-70 тысяч. У нас остается тысяч 200-300, которые идут целиком издателю на покрытие общих расходов. Почему кажется, что такая маржа огромная, так это потому, что продажи книги распределены во времени. Ты печатаешь 5 тысяч и вкладываешь вот эти деньги, условно говоря, сразу, а продают некоторые издательства её по шесть, по двенадцать месяцев. Кто-то еще больше продает, если мы говорим о деловой литературе. С электронной книгой нет этого «размазанного» процесса. И не нужно засаживать единовременно 100-200 тысяч рублей в типографию и ждать пока они окупятся. Ты должен направить деньги в редактуру, а авторские отчисления ты можешь по реализации платить. Экономика значительно меняется и поэтому потребность в оборотных средствах падает. В целом, если говорить про экономику, на электронной книге есть экономия. Главное, чтобы пользователи были научены платить. За рубежом их уже научили. Я думаю, это неминуемое, и мы тоже научим. — А каким образом можно этого добиться? Вы считаете это возможным, учитывая, что у нас множество электронных библиотек? - Отключать библиотеки. — То есть, грубо говоря, насильственными средствами? - А как иначе? С библиотеками экономические рычаги не работают. Допустим, человек нарушает закон, отнимает сумки на улицах. А вы подходите и говорите: «Знаешь, это неправильно, давай ты не будешь больше отнимать». Он отвечает: «Да, ок, ты хороший парень, мне нравишься, вот твою жену и дочку не буду обижать». А потом он отнимает у твоей мамы, а потом и у сестры... А есть люди принципиальные: «Я отнимаю сумки у всех на этой улице и мне все равно, что ты говоришь мне. Если можешь — догони, я чемпион мира по легкой атлетике». Разговор с пиратами сводится именно к такому варианту. Кому-то ты говоришь: «Ребят, не стоит выкладывать книги, это преступление». Ответ: «Да-да, хорошо». Прекращают выкладку, а через пару месяцев снова тоже самое. Мы с ними связываемся и слышим: «Да, ок, не будем». Но есть люди, которые вообще не идут на контакт. У них такая позиция, пока их не прижмешь, они будут чувствовать себя свободно и ничего делать не станут. По принципу «Сможешь – догони». Вот с ними договориться нельзя. Дать им экономическую модель? Мы даем, пожалуйста, зарабатывайте на продаже электронных книг. У нас действует одна из таких свободных реферальных программ, мы даем до 35% от наших продаж партнерам, которые помогают нам эти продажи делать. Это очень большая ставка для Рунета. Я могу сказать, что это больше, чем мы даем партнерам, которые продают наши книги у себя на сайте (Amazon и прочие). Мы ценим тех пользователей, которых нам приводят наши партнеры, рефералы. Для них это не работа. Некоторые работают, а некоторые говорят: «Извините ребята, но я так работаю, а иначе я буду терять трафик». Единственный вариант — это прижать пиратов. И, к сожалению, я других вариантов не вижу. Если издатели, авторы и мы не будем зарабатывать на книгах, то этого бизнеса не будет вовсе. Рынок должен давать деньги, иначе это не рынок. Рынок — это оплачиваемый спрос. То есть это желание потребителя заплатить за какую-то услугу или продукт. — Уже были случаи, когда успешно удавалось одолеть каких-либо пиратов? - Пока мы работали через модель «Давай ты не будешь отнимать сумочки». Сейчас у нас уже на стадии подачи искового заявления находится два или три дела. И по остальным делам полный сейф бумаг. Просто в нашей стране подача искового заявления занимает достаточно продолжительный период. Нужно заявление зафиксировать у нотариуса, а это занимает несколько недель. Затем необходимо зафиксировать нарушения, подать адвокатский запрос. Адвокатский запрос может давать ответ месяцами. По последнему случаю мы ждали ответ три месяца. Только после этого мы идем в суд, оплачиваем пошлину, и только теперь мы имеем право подавать исковое заявление. С этого момента начинают рассматривать дело. На все это тратится в среднем шесть месяцев. Но мы уверенны, что в следующем году начнут «выстреливать дела». Будем прижимать пиратов, призывать к ответу. Это не халява! Воровать интеллектуальную собственность — это преступление. Мы работаем в этом направлении и стремимся упростить эту процедуру, чтобы она не занимала 6 месяцев, как сейчас. В идеале должно быть так. Я правообладатель, у меня есть исключительные права. Я сказал, что это правило нарушено, оформил все бумаги у нотариуса, и этого должно быть достаточно для того, чтобы приостановить деятельность того или иного сайта. — А если сайт, о котором речь идет, находится не на территории РФ, а в другом государстве, где законы РФ, понятное дело не работают и не распространяются. С этим как? - «Отрубать» на уровне кабеля, входящего в Россию. Если кто-то совершил правонарушение зарубежом, то ему не дадут визу в Россию. — Но перерубить кабель на уровне Ростелекома от другого государства... - Из всех государств ведет один кабель через Ростелеком или кого-то еще и стоит какой-то фильтр на входе. Вот этого достаточно. Но, поймите, что контроль входящего трафика это только один вариант решения проблемы, существуют и альтернативы. Надо искать решение существующей проблеме. — Но вы понимаете, что сразу будет дикий скандал и много шума по поводу лишения прав... - Я понимаю, и мы к этому готовы. Пусть пираты пошумят чуть-чуть насчет нарушения прав, но не я. — Шуметь будут не они, а поборники свободы слова. - Шум — хорошая вещь — и PR. Любое изменение происходит через перелом. Насколько он болезненный — это вопрос. И нужно сделать этот перелом, иначе будут шуметь правообладатели и загнется рынок. Но если есть пираты, что с ними сделать? По-другому на них воздействовать достаточно тяжело. Я почему-то должен тратить свои деньги, до 50 тысяч долларов, чтобы их достать, и то не со стопроцентной гарантией. Зачем мне это, по-хорошему? А если он не один? А если их таких десять? Кто-то мне должен принести эти деньги, а кто мне их принесет? Почему я должен себя защищать? Я же налоги плачу, ЕСН, НДС, авторам — роялти, а они ничего не платят. И я еще должен платить деньги, чтобы их закрыли. Как такое возможно? Компания «ЛитРес» — обладатель исключительных прав на ряд произведений. — Вспоминается недавняя история с Youtube в Комсомольске-на-Амуре, где суд вынес решение заблокировать сервис «за экстремизм» вовсе — благо там провайдеров немного. В общем, закрыли, потом открыли. В итоге был большой скандал на всю страну. Вы считаете, что это вполне реально, что Вам удастся получить судебное решение, предписывающее перекрыть доступ к каким-либо пиратским ресурсам? - Если другие варианты не найдем, то придется действовать именно так. Пока я других вариантов не вижу. Для того, чтобы бегать за пиратами по всему миру материальных и физических средств нет, а государство пока не стремится помогать. Я надеюсь, что мы получим возможность воздействовать на пиратов. Даже сложно представить их количество в сети интернет. Есть информация, что в отпуске Дмитрий Медведев читал книги Стига Ларссона в электронном виде. Я вам открою тайну: прав на автора в России нет ни у кого, ни на перевод, ни на само издание на русском языке. Потребители даже не знают, что потребляют пиратский контент. Вы приходите на рынок, и вам предлагают читалку, и в ней уже как бонус записаны сто тысяч наименований книг. Вы даже не догадываетесь, что все это пиратские книги. Это называется неотрегулированное законодательство. В итоге, если ничего с этим рынком не предпринять, то завтра вам просто нечего будет читать. Будете читать Стига Ларссона, но на английском языке и платить нормальные деньги. Или будете читать самиздат. Какие-то авторы из любви к творчеству будут писать. Но они будут писать меньше книг. Может, они будут ценнее. Лев Николаевич Толстой, Александр Сергеевич Пушкин — они творили не только из любви к искусству. Ключевые их произведения были написаны за деньги, потому что мы понимаем, как это работает: есть дедлайн, есть сумма, есть интерес, и почему-то приходят и муза, и креатив. Если этот процесс не оплачивается, то нет никаких стимулов «творить». Автор в каком-то свободном режиме будет писать, писать и слушать своего выпускающего редактора тоже не будет, т.к. редактора не будет. - Коммерческие писатели, кстати, иной раз сталкиваются сейчас с ситуацией, когда им в издательстве говорят: у вас слишком хороший язык, ухудшите его. Вот это как? - Упростить, наверно. Я не издатель, мне сложно рассуждать на эту тему. — А не приведет ли это напрямую к деградации и читателя тоже? - Язык прогрессирует, и труды Ломоносова в оригинале читать и понять сложно. Упрощение языка — это нормальный процесс. Я недавно прочитал книгу «Rework: бизнес без предрассудков», и хоть это и переводная книга, прочел очень быстро, поскольку легкий язык. Не то, что написано «молодежным» языком, в просто и доступно подана информация. Донести искусство в массы не получится, потому что массы и искусство — темы разные. Люди массово в театр не ходят, даже в кинотеатр массово не ходят, честно говоря. Люди массово смотрят телевизор. Попробуйте им массово показать артхаусное кино по телевизору — например, «Весна, осень, зима и опять весна...» Ким Ки Дука. Я сомневаюсь, что вообще смотреть будут, хотя кино отличное. Поэтому если автору нужна массовость, его могут попросить упростить язык, сделать более динамичные сюжеты, упростить шутки, сделать их не такими высокоинтеллектуальными.. Если автор хочет искусства, то это, возможно, уже другой жанр и другие деньги. Но это вопрос издания книги и тут лучше спросить и профессионалов именно издания книг, а не меня, т.к. я продаю уже созданный продукт. Если электронная книга не войдет в русло рынка, то рынка не будет, никто не будет рассказывать людям, как надо писать, чтобы интерес был массовый, чтобы автор и книга были обсуждаемы. Наверняка будут проекты а-ля Гришковец: человека вроде бы никто не направлял, он сам вышел к массовости. Я не знаю его издательскую и редакторскую карьеру, может, его кто и направлял. Наверняка такие мэтры останутся, но их будет меньше, интенсивность писания так же будет снижаться, да много ещё чего будет меньше. Отец мультитача о будущем интерфейсов Андрей Письменный Опубликовано 01 декабря 2010 года В одном из просторных кабинетов новенького офиса Microsoft в Крылатском страшная кутерьма. Двое операторов устанавливают видеокамеру и свет, PR-менеджер нервно крутит в руках телефон, время от времени заглядывают ещё какие-то люди. Я сижу в кресле, искоса поглядываю на экран макбука (его попросили отодвинуть подальше — чтобы в кадр не попадал) и тоже слегка нервничаю. Напротив меня — ещё одно кресло, пока пустующее. С минуты на минуту его должен занять гость из Штатов, к приезду которого, собственно, все так судорожно готовятся. Билл Бакстон не известен широкой публике, однако в своей области его можно считать очень весомой фигурой. В 1985 году, за четверть века до айпада, он разработал графический планшет с поддержкой мультитача. От нынешних сенсорных дисплеев тот отличался разве что отсутствием экрана под чувствительной поверхностью. Бакстон до сих пор трудится в области исследования человекомашинного взаимодействия и интерфейсов. Он успел поработать в легендарном Xerox PARC и компании Silicon Graphics, получить три докторских степени и множество наград за свои изобретения, преподавать в университете Торонто, написать несколько колонок в журнал BusinessWeek и книжку Sketching User Experiences. С 2005 года Билл Бакстон занимает должность старшего исследователя в Microsoft Research и продолжает свои разработки. Все эти (и ещё многие сюда не уместившиеся) титулы и достижения не помешали Бакстону оказаться милейшим и обаятельнейшим дедушкой в безразмерном свитере. Стоило ему появиться на пороге комнаты и поздороваться с собравшимися своим ласковым баритоном, как напряжённая атмосфера в момент рассеялась. Рассеялись и мои опасения о том, что человека из Microsoft, возможно, придётся долго допрашивать, прежде чем он перестанет говорить заученными рекламными фразами. От корпоративных ценностей Бакстон оказался поразительно далёк, а на любой вопрос отвечал захватывающей дух речью.  На следующий после интервью день Билл Бакстон выступил на конференции User Experience Russia 2010 На следующий после интервью день Билл Бакстон выступил на конференции User Experience Russia 2010 - Расскажите для начала о своей работе. Каково это вообще — работать в Microsoft Research? - Microsoft Research во многом напоминает университет, в частности — своим устройством. Моя работа похожа на работу профессора в научной лаборатории — за тем лишь исключением, что не нужно преподавать. У нас есть исследовательские проекты, а моя специальность — человекомашинное взаимодействие: жесты, устройства ввода и так далее. Мы ставим эксперименты, делаем прототипы, тестируем их, а потом показываем результаты на научных конференциях — к примеру, на этой неделе в Нью-Йорке проходит конференция, посвящённая техническим аспектам пользовательских интерфейсов. Там мы представим нашу работу о вводе данных, задействующем обе руки — так, чтобы можно было использовать прикосновение и перо одновременно. Последний проект моей группы призван доказать, что само противопоставление пера и прикосновения неверен, потому что их лучше всего использовать вместе. Иногда одно, иногда другое, но зачастую лучше всего — вместе.

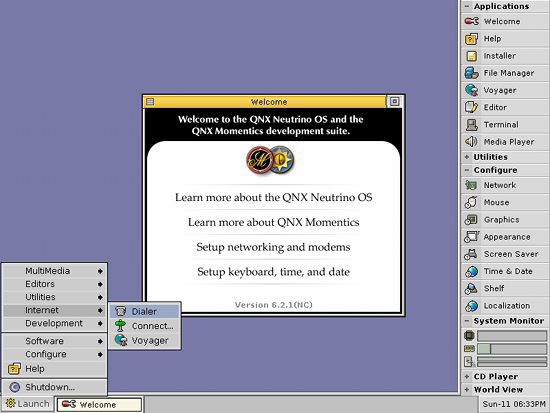

В Microsoft тысяча человек вроде меня, и им удаётся покрыть все области знания: компьютерную науку, инженерные аспекты, даже физику, физиологию, социологию и психологию. Это контекст для всего, связанного с компьютерами. Каждый из нас старается понять, как каждая из этих дисциплин может помочь бизнесу и старается сделать свою разработку важной для компании. - Вы, наверное, много взаимодействуете с другими исследовательскими группами? - Да, я думаю, это моя личная черта. Кажется, я не сделал ни одного проекта, который бы не подразумевал взаимодействия с другими исследовательскими группами — как внутри Microsoft, так и с продуктовыми группами, а нередко — и со специалистами из других стран. Мне важно общение с людьми, имеющими опыт в разных областях — их взгляды на мир различаются поразительным образом. Когда я зову их участвовать в моих проектах или помогаю с их разработками, у меня куда больше шанс чему-то научиться или сделать что-то неординарное. - Проекты Microsoft Research редко воплощаются в том виде, в котором разрабатывались. Вы можете рассказать, какие из ваших проектов нашли применение в конечных продуктах? - В компьютерной технике и телекоме нужно минимум двадцать лет, чтобы новая идея стала по-настоящему популярной. Многие удивляются: «Как такое возможно?» Технологии же развиваются очень быстро, почему же момент изобретения и широкое применение разделяют десятилетия? Приведу несколько примеров. Мышь изобрели в 1965 году. Я сам использовал одну из них в 1971. В Xerox PARC мышь появилась в 1973. К Apple Macintosh мышь прилагалась с 1984. Но только в 1995, когда вышла Windows 95, мыши действительно распространились повсеместно. Ещё пример. Я работал над мультитачем в 1984, а в 1985 опубликовал статью об этом. Но всё равно никто, кроме профессионалов, не знал о мультитаче до 2007 года, когда появились два продукта: Microsoft Surface и Apple iPhone. И внезапно мультитач стал великолепной новой штукой. Новой штукой — из 1985 года! - Значит, сейчас вы работаете над проектами, время которых настанет через двадцать лет? - Конечно. Такая у меня работа. Это не значит, что некоторые идеи не всплывут раньше, но многие проекты Microsoft Research действительно рассчитаны на двадцатилетний период. Надеемся, конечно, что хватит и десяти лет, но все понимают, что может потребоваться и двадцать. У нас есть и такие подразделения как Office Labs и Live Labs — это уже не исследователи, а, скорее, разработчики. Они берут идеи исследователей и думают над тем, как использовать в продуктах. Об исследовательских проектах нужно думать, как думают банкиры: есть деньги, их нужно инвестировать. Часть из них должна окупиться быстро, часть — медленно. В Microsoft Research рассматривают долгосрочные перспективы, в Labs — среднесрочные, а в продуктовых группах — ближайшее будущее, не дальше пяти лет. Microsoft Surface — хороший пример. Он появился в последние пять лет, хотя некоторым наработкам, которые в нём применили — не меньше пятнадцати лет. Огромную работу проделали без лишней шумихи, просто в какой-то момент все смогли увидеть результат. Другой пример — Kinect для Xbox 360, технологию для которого создали в кембриджской лаборатории Microsoft Research в Великобритании. У нас там есть таланты мирового уровня, специализирующиеся на машинном зрении. Они разработали систему трёхмерного распознавания, лёгшую в основу Kinect. На их счету важная научная работа в области математики, благодаря которой распознавание жестов стало возможным. - Kinect всё-таки стал конечным продуктом. Surface — тоже, но шумиха вокруг него быстро закончилась, и с тех пор про него ничего не слышно. Можно ли его считать успешным?

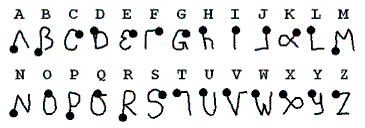

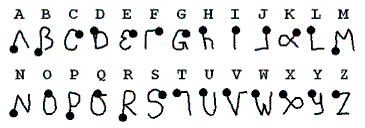

- О «Кинекте» много говорят, потому что это продукт для всех, к тому же он только-только начал продаваться. С Surface всё не так просто. Он ведёт за собой куда более важные изменения, да и сама технология куда сложнее. Конечно, хотелось бы, чтобы всё происходило быстрее. Создать телефон, плеер или новый тип компьютера можно довольно быстро. Но Surface — куда более амбициозный проект, и здесь немало сложностей. Сперва нужно сделать так, чтобы «железо» заработало, затем — софт, а уже потом нужно думать, как заставить то и другое работать вместе. «Железо» нынешней версии Surface впечатляет, но при этом оно дорогое и довольно неуклюжее. Нам удалось достичь немалого успеха в крошечной рыночной нише. Поскольку Surface сложно и дорого изготовлять, мы решили сконцентрироваться на узких и практически незаметных для широкой публики рынках. - И что это за рынки? - Области вроде ритейла, банков, отелей... - Можно сказать, что там Surface действительно используют? - Используют. Есть магазины, в которых можно взять товар, положить на Surface и изучить дополнительную информацию, но таких мест не очень много. И это, на самом деле, хорошо, потому что сперва лучше найти узкую область, в которой есть шанс достичь настоящего успеха. Пользователи довольны Surface, но они, скорее, бета-тестеры (хоть официально Surface и не считается «бетой»). И у нас теперь есть несколько лет опыта использования устройства, и мы знаем, как улучшать софт и систему. Мы знаем, что аппаратная часть станет проще и дешевле. Так всегда происходит с технологиями — упрощение и миниатюризация потихоньку меняют всю экономику производства. Иногда новая технология кажется совершенно ужасной — для неё нет ни софта, ни достойного применения, и люди просто не знают, как её использовать. Мы не можем позволить этому произойти. Благодаря тому, что с Surface мы работаем уже несколько лет, мы будем готовы к появлению следующего поколения «железа», и новый софт от этого выиграет. Surface очень интересен, потому что это далеко не просто стол и не просто экран с мультитачем. Самое важное в Surface — то, что экран одновременно служит оптическим сенсором — наподобие сканера. На него можно положить документ или объект, и устройство его «увидит». Оно реагирует и на пальцы, что обеспечивает мультитач, но в отличие от ёмкостного или резистивного экрана Surface не только воспринимает прикосновения, но и по-настоящему видит объекты, сканирует и оцифровывает их. Это самое замечательное. - Ну да, мы все видели демонстрации. Есть ещё один интересный продукт, о котором я хотел вас расспросить. Он назывался InkSeine, и, кажется, впоследствии какие-то его элементы были использованы в многострадальном Microsoft Courier. Со стороны он многим кажется неудачей, но вы наверняка знаете куда больше. - Конечно. Это разработка как раз моей группы. InkSeine создал один из моих ближайших коллег — Кен Хинкли. Как раз о нём я говорил, когда упомянул сотрудника, который демонстрирует в Нью-Йорке наш проект, сблизивший тач с перьевым вводом. - То есть работа движется? - Конечно! Пока что это всё лишь исследования, но у нас есть, что показать. Другая группа в Microsoft Research разработала замечательную программу для рисования — Gustav. В отличие от других программ для рисования на компьютере, она по-настоящему моделирует физику красок. Мел, к примеру, будет отличаться от масляной краски — её можно смешивать пальцами, а мел — размазывать и так далее. Рисовать при этом можно и пером, а пальцами — подправлять или же двигать и масштабировать холст. Получается, что пальцы и кисть можно использовать одновременно. Я знал, что вы упомяните Courier. Наша цель — доводить до рынка хорошие технологии, но иногда бывает так, что конечный продукт не так важен. Идеи продолжают развиваться, научные статьи публикуются... - То приложение с красками производит впечатление очень «аналогового» что ли. Вам не кажется, что правильнее было бы не пытаться эмулировать аналоговое, а придумать, как извлечь пользу из того, что у компьютеров получается лучше? - О, это отличный вопрос, я рад, что вы его задали. Это, на самом деле, больше похоже на выбор тактики. Когда новая технология готова к использованию, людей нужно убедить в том, что она работает. Для этого стоит сделать знакомую всем вещь, но на цифровой основе. Её можно показать всем и сказать «попробуйте». Вместо того, чтобы решать, вы правы или я, лучше всего попробовать и прислушаться к своим ощущениям. Вы уже использовали компьютер раньше и сперва отзовётесь негативно. Потом скажете: «Но я же не художник, зачем мне краски? Я инженер или музыкант или банкир или в игру хочу поиграть — не важно». Я отвечу: «Я это понимаю, но зато теперь мне стала понятна физиологическая сторона. У тебя ведь две руки?» — «Что за глупый вопрос? Конечно!» — «Ну и почему ты всю жизнь используешь только одну при работе с мышью (кроме тех моментов, когда приходится печатать)?». Как использовать обе руки при работе с компьютером? Когда мы пишем на листе бумаги, мы обычно не просто водим по нему карандашом, вторая рука при этом обязательно придерживает и направляет лист. При письме руку комфортно передвигать примерно на шесть сантиметров — не больше. Это можно учесть, причём даже в работе, к примеру, с электронными таблицами. Приведу пример ещё лучше. Представьте, что я работаю с небольшим устройством — величиной с мобильный телефон. Там у меня есть карта, и я хочу показать на ней, как добраться из аэропорта до московского офиса Microsoft. Если карта умещается на экране целиком, то от неё никакого прока — слишком мелко. Её нужно приблизить и начать рисовать на ней путь, но разве это не безумие — нарисовать три линии, подвинуть, нарисовать ещё три линии, передвинуть и так далее? Гораздо лучше было бы водить устройством так, будто оно — увеличительное стекло над реальной, но невидимой картой. Гироскоп, акселерометр или поток оптических данных со встроенной камеры в этом помогут. Тогда можно будет передвигаться над «картой» и, будто мы управляем камерой, приближать телефон для разглядывания деталей или отдалять для того, чтобы осмотреться. Вот тогда можно будет и рисовать, и передвигать карту, и говорить одновременно, а потом отправить в виде сообщения — к примеру, в машину, а её навигационная система отобразит послание. В какой-то момент становится понятно, что работа с картой очень напоминает рисование! Двигаться по карте — в точности то же самое, что двигать холст в «Густаве». Представьте себе такую ситуацию: вам нужно добираться сюда, а у вас дома проблема с окном. Нужно вызвать ремонтников, но поломка — в определённом месте одного из окон. Времени ждать и показывать нет, потому что нужно по делам. Вы выходите из дома, берёте с собой камерофон и фотографируете фасад. А потом помечаете на картинке нужное место и отправляете в виде сообщения рабочим. В телефоне есть тачскрин, камера и микрофон. Но почему-то ни один из телефонов пока что не позволяет делать то, что я описал, хотя это и было бы ценно. Заметьте, что в этих примерах вы рисуете, но не что-то художественное, а аннотацию. Возвращаясь к вашему вопросу, программа для рисования эмулирует старый способ рисовать, но само рисование здесь не имеет особого значения. Что имеет значение — так это умения людей, те умения, которые у нас есть всю жизнь и которые мы применяем в обычном мире. Если придумать, как использовать этот потенциал и эти навыки, то можно перейти на другой уровень абстракции: речь пойдёт уже не о рисовании, а о манипуляции объектами, аннотировании и объединении этих действий. Это уже не просто навигация, увеличение или перемещение — ведь одновременно можно что-то помечать и отдавать голосовые команды. Представьте, что такую схему будут использовать для других типов документов. Что изменится, если к ним можно будет применять те же навыки? Получается уже не эмуляция, а нечто инновационное — ведь мы переносим уже известные принципы на другие задачи и другие устройства — Surface, планшет, мобильный телефон или даже настенную доску. И выходит, что это не просто копирование чего-то старого, а использованее лучшего, что могут дать цифровые технологии, и лучшего — из того, что умеют люди. Вообще говоря, я довольно подробно изучал традиционные медиа, но мои исследования лежат вовсе не в области софта или железа. Их предмет — люди. Как они устроены? Что сделать, чтобы технология учитывала их способности? Ваш вопрос хорош тем, что позволил показать, как двигаться от копирования к инновации. - Что ж, убедительный ответ! Но давайте подробнее поговорим о тачскринах. Они были изобретены давно, но за последние пару лет внезапно стали мейнстримом. Что, по-вашему, послужило толчком к их распространению? - Первые тачскрины действительно были изобретены в 1965 году — примерно тогда же, что и первые мыши. В 1972-73 в Иллинойском университете был проект по компьютерному обучению. К 1974 в школьных классах по всему Иллинойсу стояли компьютеры с плазменными панелями (которые изобрели там же) и поддержкой тача, и ими пользовались семилетние дети. - Повезло детям!  - Ещё как! Система досталась не исследователям или бизнесменам, а детям. Называлась она PLATO. Резонный вопрос — что же случилось с этой разработкой? У меня есть большая коллекция гаджетов. Давайте покажу вам один из них. Смотрите, это просто часы, они похожи на те, что я ношу сейчас — у них есть циферблат и ещё небольшой экранчик внизу. Их роднит ещё одна вещь — и те, и другие снабжены тачскринами. В этих старых часах есть калькулятор. Нажимаем вот на эту кнопку, на экране появляются буквы CAL — «калькулятор». Мне нужно ввести цифры — я их просто рисую на поверхности. Рисуем "1" — появляется единица. Теперь пишем "7", чтобы вышло «17». Теперь знак "+", "3" и знак "=". - Впечатляет. - Да, здорово. Вы технический журналист и наверняка должны знать, когда такие часы стоили дешевле ста долларов. - Несколько лет назад? - Сколько именно? - Пять? Десять? - Ещё. - Пятнадцать? - Нет! - Двадцать? - Тоже нет! - Двадцать пять, может быть? Вряд ли больше. - Двадцать шесть!  - Эти часы — с тачскрином, распознаванием рукописного ввода и калькулятором, были сделаны и продавались в магазинах по всему миру в 1984 году. В том же году, когда появился первый Macintosh. Ещё раз: 1984 год, дешевле ста долларов, тачскрин, распознавание рукописного ввода, размер обычных часов... Всего через десять лет после PLATO. Да что мы вообще делали последние 26 лет?! Вам наверняка известен закон Мура. Число транзисторов, умещающихся на кристалле определённого размера, удваивается каждые 18 месяцев. Чтобы получить число за последние 26 лет, нужно умножить 26 на 12 и поделить на 18 — получится, что с тех пор, когда появились эти часы, число транзисторов, умещающихся на чипе, удвоилось семнадцать раз. Если бы микросхема, отвечавшая в этих часах за распознавание символов и обработку информации с тачскрина, создали сегодня, в ней при том же размере было бы в 217 раз больше транзисторов - Не могу поверить, что они продавались на Земле, а не где-нибудь на Альфе Центавра. - Эта штука, конечно, довольно медленная и распознаёт не идеально. Сегодня можно сделать куда лучше — как Graffiti. И ещё один нюанс. Мы живём в век «Твиттера» и SMS, и каждый, кто пишет на телефоне, делает это большими пальцами, уставившись в экран — чтобы не пропустить ошибку. Я могу показать вам тачскрин двадцатишестилетней давности, на котром можно было писать, не глядя. Ввод текста на нём не был привязан к пространству, не нужно было попадать по крошечным целям. На нём нужно было рисовать, а это мы все умеем делать.

Люди часто думают, что исследования (в частности, в Microsoft Research) — это обязательно изобретение новых продуктов. Отчасти это правда. Но традиционная форма исследования — к примеру, в истории или социологии — это не изобретение, а изучение прошлого и последующие попытки осмыслить, понять и применить к новым условиям. Лично я половину времени изучаю прошлое, пытаясь осмыслить случаи, похожие на те, которые я описал. Это важнейшие прототипы, и я их не создал, а просто купил, и они помогают понять, как, к примеру, сделать лучший смартфон. Кстати, у меня есть первый в мире смартфон. Давайте я вам его опишу, хотя бы для смеха. Представьте такой телефон — у него три кнопки (включение-выключение и регулировка звука), а всё остальное делается при помощи тачскрина: звонки, адресная книга, календарь... Что я сейчас описал? - Боюсь, трюк не пройдёт — я смотрел ваши статьи и видел упоминание этого телефона. И это не iPhone. — Да, он назывался Simon. Джонатан Айв, который создал iPhone, а до этого работал над Newton, наверняка знал про Simon. Все эти идеи не новы — они эволюционируют.  У Simon не было мультитача, у моей разработки — был, но всё равно и то, и другое уже в прошлом. Залог успеха продукта — не в какой-то единственной технологии. Технологию можно сделать за год или за два, гораздо сложнее интегрировать её в экосистему других технологий (в том числе и устаревших). Почему Simon провалился, а iPhone — нет? Всё дело во времени. Когда создавался Simon, телефоны были дорогими, а скорость передачи данных — низкой. У Simon не было веб-браузера — просто потому что веб в 1993 году ещё не изобрели. Хотя вещи вроде «Саймона» или тех часов обычно остаются неизвестными, благодаря им можно многое узнать. Это яркие представители технологий, проходящих период инкубации и готовых воплотиться в новый продукт. А значит, что и сейчас имеется много вещей, которым уже десять или пятнадцать лет, и которые готовы к новому рождению. - Понятно — значит, всё дело не только в тачскринах, но во всей совокупности технологий... - Конечно. Сколько лет мы уже слышим, что распознавание рукописного ввода появится в следующем году? (В России, кстати, лучшие специалисты в этой области. Это сложная математическая задача, а тут много отличных математиков.) А что с распознаванием речи? Все говорят, что оно вот-вот станет повсеместным. Говорят причём уже лет тридцать. Тем временем распознавание речи действительно мало-помалу начинает работать. Кстати, занятная деталь с распознаванием: его точность всегда составляла 98%, просто тесты всё время становятся всё сложнее и сложнее. И ещё нужно понять, как объединить эти технологии вместе. Когда ведёшь машину, телефон действительно должен управляться исключительно голосом. А вот если я лечу на самолёте в Сан-Хосе и хочу по телефону рассказать что-то важное, меня могут и уволить, потому что рядом легко может сидеть кто-нибудь из конкурентов. Зато если я буду писать, никто ничего не узнает. А бывают случаи, когда нужно и писать, и говорить одновременно — как в примере с отправкой фотографии с пометками. Это действительно всё усложняет. Когда я начинал работать с компьютерами в 1971 году, они были приписаны к лабораториям и выполняли строго определённые задачи. Сейчас компьютеры повсюду, и их задачи становятся всё сложнее. - Сейчас мультитач уже относительно распространён. Как вы думаете, его потенциал уже используется полностью, или ещё есть, что добавить? - Добавить — многое. Даже в случае с телефонами — у них есть мультитач, можно использовать и перо или голосовой ввод, но эти возможности используются не одинаково хорошо, что уж говорить об использовании всех трёх сразу. Вот что людям даётся легко, а компьютерам — сложно, так это одновременные действия. Мы всегда находим способ объединить две-три простые задачи в одну цельную, но лёгкую в исполнении. Я могу находить дорогу на карте или рисовать поверх фотографии и менять масштаб по ходу дела. На телефоне эти действия никак не выполнить одновременно. Если же их можно будет делать одновременно, да ещё и одной рукой, то вторую можно будет задействовать ещё для чего-нибудь, а затем и голос. Это куда более естественное поведение — и его ещё предстоит воплотить. Но это ещё не весь ответ. В ближайшие лет пять индустрия сможет произвести действительно хорошие и хорошо спроектированные гаджеты. Но индустрии ещё есть к чему стремиться. - Есть ли, по вашему, какие-то тупики, связанные с развитием новых интерфейсов — мультитача в частности? - Конечно. У меня есть правило, я его часто повторяю: любая вещь хороша в одном случае, но не годится — в другом. Компетентный дизайнер должен знать, что он делает, для кого, когда и почему. Когда ко мне приходит дизайнер и говорит, что он изобрёл новую технологию, я первым делом говорю, что это очень интересно, и тут же спрашиваю, в чём подвох. В чём эта вещь бестолкова? Если дизайнер не знает, я ему отвечаю, что работа не готова, он ещё не понимает, что делает, и что нужно вернуться к проектированию. Или же я собираю группу, и мы ищем недостатки вместе.

Так или иначе, я должен рассмотреть проблему со всех сторон. Только поняв недостатки, можно сосредотачиваться на достоинствах. Мало кто об этом задумывается, а ведь именно это умение отличает просто умного человека от профессионального дизайнера или исследователя. Что касается именно мультитача, то он хорош для многого, но как и всё — для чего-то бесполезен. Для того же рисования: не зря же Пикассо использовал кисть, а не рисовал пальцем как пятилетний ребёнок. Но это не значит, что он вообще ничего не трогал руками. До чего же можно и нужно дотрагиваться? Есть хорошие примеры. Взгляните на руки — может показаться, что мы используем в основном правую руку, и что левая не так уж важна. Но это не так. Левая настолько же специализирована, насколько и правая — просто нужна для другого: поддерживать, обхватывать и так далее. У меня есть коллега — французский психолог Ив Гиар, он рассказал мне много интересного — в том числе о том, как мы пишем. Билл Бакстон рассказывает о наблюдениях Ива Гиара, посвящённых письму на бумаге Или, к примеру, историю о том, что пуговицы на женской одежде расположены с неверной стороны. Не просто с другой, а именно с неверной. Работает это так: сперва человек подносит свою недоминирующую руку (для большинства — левую) и нащупывает ей то место, где будет производиться действие, затем следует доминирующая рука, подтягивает вторую часть куда нужно, и делает завершающее движение. Так мы действуем и когда вдеваем нить в иголку и когда застёгиваем пуговицы и в прочих похожих ситуациях. Потому у мужчин пуговицы расположены с нужной с точки зрения правши стороны. Почему же у женщин не так? Ответ оказывается очень забавным. Исторически сложилось так, что первые платья с пуговицами были очень дорогими — позволить их себе могли только богачи, а бедняки подвязывали одежду — примерно так [кивает на закутанную в шаль пиарщицу Microsoft]. Богатым женщинам не нужно было одеваться самостоятельно — для этого у них имелись слуги. И пуговицы располагались таким образом, чтобы слугам было удобно. А сегодня только мужчины могут получить выгоду из такого расположения пуговиц на женской одежде. Видите, даже в истории одежды можно найти уроки, полезные для понимания естественных интерфейсов. Технологии всё время меняются, а вот способ использовать руки — нет. Если изучить и понять это, то и жестовые интерфейсы сразу становятся понятнее. Появится понимание того, как сделать жесты для Kinect или Surface или мобильного телефона. Как решить, в какой руке он должен находиться при том или ином действии? К какому движению какое действие приязать? Как они взаимосвязаны? Что нужно делать одновременно, а что — поочерёдно? Нужно понять, как все эти вещи делать правильно. Я уверен, что мы до этого дойдём в ближайшие пять лет плюс минус два года.

Что мне кажется куда большей проблемой — это взаимодействие разных устройств. Я думаю, что в будущем никто уже не будет восхищаться одним прекрасно работающим гаджетом — будь он производства Microsoft, Apple, Philips или Sony. Ну кроме, конечно, особенных любителей гаджетов. Сегодня мы рады просто тому, как работает новый телефон, но в будущем куда важнее станет слаженная работа всей экосистемы. Пока что она раздроблена на несколько островков, плохо взаимодействующих друг с другом. Мой Palm Pilot был в некотором роде лучше моего нынешнего смартфона: чтобы передать визитку через Palm, нужно было просто направить одно устройство на другое и нажать кнопку. Это было абсолютно безопасно, потому что данные передавались по инфракрасному порту, и обязательно было находиться в зоне прямой видимости. С Bluetooth или Wi-Fi не только сложнее установить связь, но и сигнал идёт непонятно куда. Я, конечно, не говорю, что IR лучше, чем Bluetooth (помните, я говорил, что любая вещь хороша для одного и плоха для другого?). У IR множество проблем, но он позволяет передать сигнал в строго определённом направлении, а для некоторых задач это очень важно. Для Bluetooth ничего похожего нет. Я жду не дождусь, к примеру, появления электронных досок, на которые можно было бы передать информацию во время выступления и пальцем указывать на слайды, поясняя те или иные вещи. Вот, к примеру, почему эта буква 'R' перевёрнута [показывает на букву "Я" на плакате]. Такое непросто реализовать — особенно если одновременно думать о других вещах — о той же безопасности — ведь придётся везде расставить камеры. Мы часто создаём новые технологии, которые усложняют мир — один синдром очередного лишнего пульта в гостиной чего стоит. В ближайшее пятилетие мы начнём двигаться в другую сторону — каждая новая технология будет упрощать жизнь, а не усложнять. - То есть вы считаете, что будущее — за плотной интеграцией разных устройств и технологий? - Я думаю, что интеграция очень важна — это одна из причин, по которым я работаю в Microsoft. Эта компания участвует в большом числе самых разных бизнесов. С одной стороны, размеры компании, конечно, во многом её ограничивают, но с другой — позволяют найти специалиста практически из любой области. - Ещё один вопрос о будущем интерфейсов. Если мультитач и связанные с ним вещи — это сегодняшний день или ближайшее будущее, то что нас ждёт дальше? - Есть ещё много сенсоров, которые можно задействовать. Тем же телефоном куда легче пользоваться не посредством взаимодействия с экраном, а просто перемещая его в пространстве. С нынешнем поколением акселерометров и гироскопов это довольно сложно реализовать (особенно зум). Я думаю, мы увидим в гаджетах и другие сенсоры... С другой стороны, конечно, с Surface так не поработаешь, если ты не Супермен. В общем, это зависит от устройства. Мне, к примеру, интересно, что должно произойти, чтобы люди снова начали носить часы. Я, наверное, в этой комнате единственный человек с наручными часами. Люди перестали носить часы, потому что они есть в телефонах. Сегодня часы — это скорее украшение. С другой стороны, и гаджеты постепенно становятся чем-то вроде украшений. - Как вы думаете, экранные клавиатуры со временем станут неактуальными? - Я думаю, экранные клавиатуры неплохи, если нужно сделать пару несложных вещей. Но очень сомневаюсь, что из обычной клавиатуры и сенсорной вы бы для написания статьи выбрали сенсорную. На ней практически невозможно печатать вслепую. Механическая клавиатура — прекрасное изобретение, и я не думаю, что оно в ближайшее время потеряет актуальность. Лично я терпеть не могу экранные клавиатуры. Я думаю, даже это [указывает на те самые часы с тачскрином] удобнее. Потому что ими можно пользоваться, не склоняя голову, они точнее распознают текст и никаких проблем со слишком толстыми пальцами. - Выходит, нынешние телефоны в этом плане отстают от Palm Pilot пятнадцатилетней давности? - Graffiti в Palm Pilot вырос из моего изобретения. Я занимался разработкой первой системы компьютерного ввода при помощи условных символов.  Система Graffiti, использовавшаяся в карманных компьютерах Palm Система Graffiti, использовавшаяся в карманных компьютерах Palm Мы до сих пор очень слабо продвинулись в этой области, а ведь улучшить что-то не так уж сложно. Никто уже не помнит, а в старых телефонах Microsoft была очень интересная система. Каждое нажатие на клавишу требует времени, и всегда есть вероятность совершить ошибку. Обычно для того, чтобы ввести заглавную букву, нужно нажать Shift, а затем нужный символ. Мы же сделали экранную клавиатуру, где нужно было нажать и провести пальцем наверх, чтобы выбрать заглавную букву. Для переноса строки тоже использовался жест — вниз и налево. Я никого не призываю избавляться от экранных клавиатур — они полезны. Но они не могут быть заменой, а лишь дополнением. И даже если приходится пользоваться экранными клавиатурами, их можно значительно улучшить. Причём речь пока что идёт лишь о каких-то элементарных вещах. Если их до сих пор никак не доделают, то откуда ждать более сложных нововведений? - Вы говорили, что телефону Simon не хватает браузера. А теперь становится понятно, что интернет плохо приспособлен к новым устройствам. Или же можно как-то лучше приспособить мобильные устройства для интернета? - От этого, конечно, все страдают. Есть прекрасные, но сделанные для 24-дюймовых мониторов веб-страницы, которые становятся бесполезными на экране телефона. Даже «Википедией» на телефоне пользоваться не так просто. Рынок рано или поздно изменит дизайн онлайнового контента. Всё больше людей пользуется интернетом с телефонов, а значит даже думать о создании контента нужно по-другому. Один из моих исследовательских проектов, ещё в Silicon Graphics, включал в себя серьёзную работу, посвящённую онлайновым страницам, которые выглядели по-разному в зависимости от того, где ты находишься, и даже что делаешь. Данные в зависимости от этого предоставлялись в том виде, в котором они могли понадобиться. Похожая история произошла с ноутбуками — их поначалу видели как портативные версии настольных компьютеров. Телефоны тоже сперва выглядели как крошечные версии десктопа. Но это то же самое, что считать флейту — маленькой трубой. Это разные инструменты, у них разный язык. В случае с телефонами — отчасти, конечно, дело в «железе», но существенная доля проблемы — в контенте. И у Microsoft и у компаний вроде Adobe есть наработки в этой области. Microsoft Expression Blend — одна из них. - В вашей биографии есть пункт об исследовании, связанном с законом Фиттса. Считаете ли вы, что идеи о дизайне можно доказать при помощи формул? - Отчасти это так. Единственный способ узнать, правильно ли что-то — проверить. Теория даёт некое приближение к этому. Когда есть идея, лучше хотя бы на салфетке прикинуть, как она будет работать на практике, чтобы потом продолжить исследования на более высоком уровне. Или когда что-то не работает — я могу спросить «почему?» и проверить. Помните, я говорил о слишком мелких клавишах? Если знать размер клавиатуры и размер клавиши, то можно посчитать, насколько быстро получится печатать. Уже после нескольких тестов можно сказать, насколько, к примеру, нужно увеличить расстояние между клавишами, и как это повлияет на результат. Если же результаты тестов окажутся хуже нашего предположения, значит либо теория неверна, либо реализация хромает. Ну а если результаты окажутся лучше обычного, значит, это чудеса науки. Так или иначе, теоретическая основа позволяет достигать большей эффективности. - Сейчас много разговоров об A/B-тестировании. В Google, к примеру, это очень популярная методика. Что вы о ней думаете? - Я считаю, что A/B-тестирования недостаточно. Это, конечно, не плохая практика, потому что традиционно в компьютерной индустрии делалось только «A-тестирование», мы сравнивали "A" с "A" — то есть работает или нет. Но по моим наблюдениям, в дизайне никогда не бывает меньше пяти решений. Когда работаешь с фокус-группой и спрашиваешь, нравится ли продукт и готовы ли люди его купить, если показать только один вариант, никто не скажет «я бы никогда не стал использовать эту дребедень». Уже хотя бы потому что они не хотят тебя обижать. Ну и вообще, люди всегда ставят оценики выше, чем им кажется — потому что думают: «вдруг это я дурак, а не программа дурацкая?».